Historia del graphicwhorismo II: shaders y la peluca de John Romero

Segunda entrada de la apasionante saga de textos sobre el graphicwhorismo. Si te perdiste la primera, la tienes aquí.

Shaders, ¡shaders!

La guerra entre tarjetas gráficas y motores estaba servida: todos querían demostrar que la tenían más grande. Más polígonos, más efectos, más texturas, más chorradas. Todo para conseguir las imágenes más “bonitas”, los juegos más “realistas”.

Pero esa guerra tenía un claro límite: las tarjetas gráficas ofrecían cada vez más potencia en términos de cómputo, pero eran “fijas”. El término fixed function pipeline significa que el pipeline ofrecido por la gráfica era fijo: si querías mandar a la gráfica algo que no fuera lo permitido por ellos (vértices, colores, normales, texturas y poco más), estabas jodido. No se podía manipular cómo se dibujaban las superficies, más allá de definir colores o usar “multitexturas” para poner por encima sombras precalculadas (lightmaps). Hacer efectos en toda la pantalla era doloroso (ni bloom ni pollas), y en general la capacidad creativa de la gente estaba muy limitada.

Si sólo tuviera un gameplay a la altura…

Así que el siguiente paso para las tarjetas gráficas estaba cantado: tenían que convertirse en procesadores completamente independientes, con su RAM, sus núcleos y toda la mandanga. Tenían que dejar de ser simples “extras” para calcular píxeles y hacer multiplicaciones para convertirse en lo que hoy en día se conoce como GPU: una CPU hecha específicamente para gráficos.

Obviamente no fue un cambio de la noche para la mañana: aquello tardó, el soporte al principio no fue bueno, y la carrera del graphicwhorismo no hizo más que empeorar durante los primeros años (¿quién no se acuerda todavía de los putos “shader model” 2, 3, 4, 5…?). Pero los “shaders” estaban ahora entre nosotros, lo que significaba libertad total para los programadores gráficos.

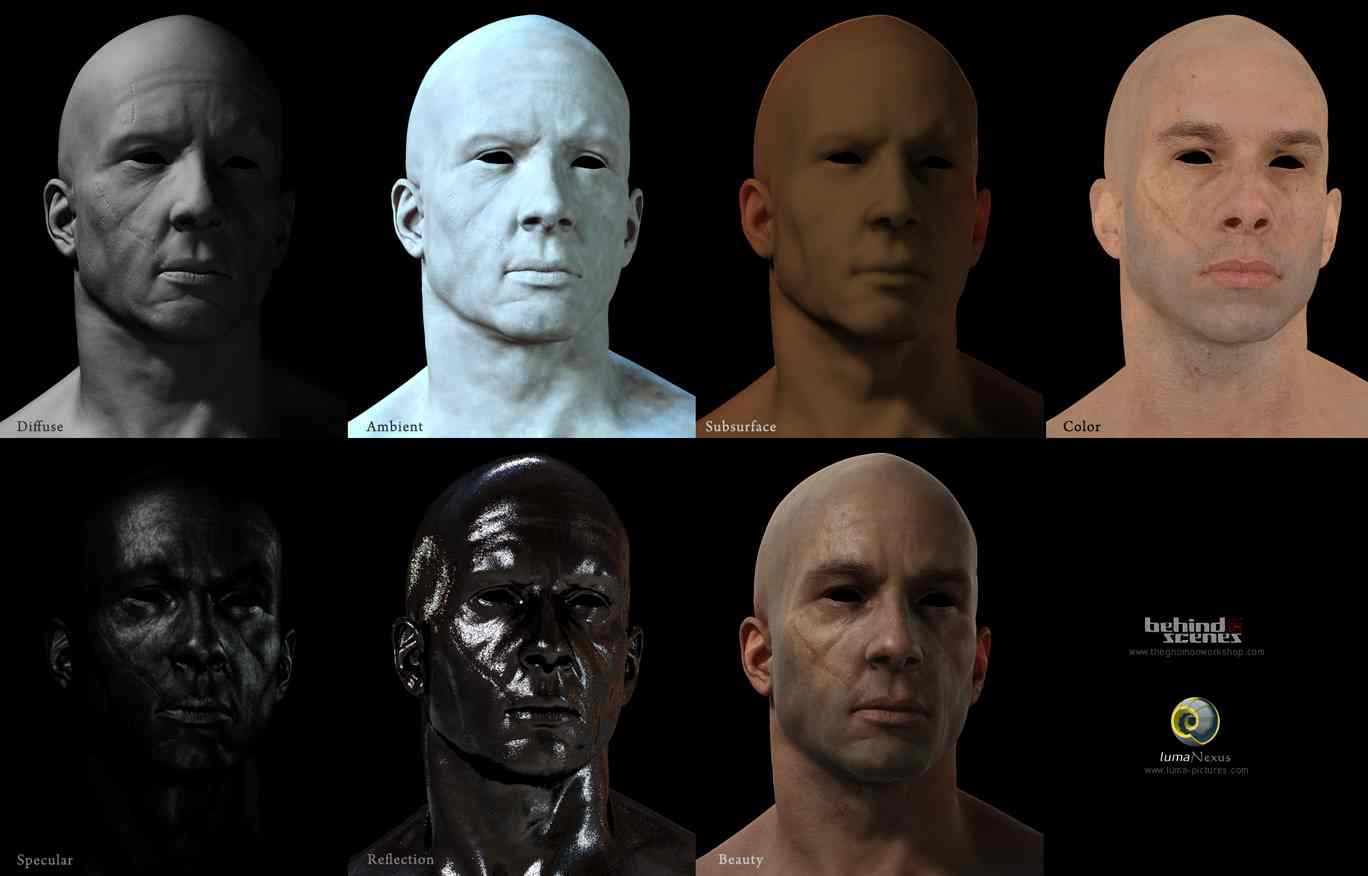

Pero ¿qué es un shader? Un shader es un pequeño programa escrito en un lenguaje propio (GLSL, HLSL, Cg… o ensamblador de la gráfica misma – el puto horror), que se compila y ejecuta en la GPU. Gracias a eso es posible decidir cómo mostrar en pantalla cada elemento – desde los objetos hasta la UI o la imagen final en sí misma, con efectos de postprocesado de todo tipo. Palabrejos como “bloom“, “HDR“, “SSAO” y demás empezaron a sonar cada vez más en el vocabulario de los hardcore gamers y graphicwhores en general.

Crysis me pareció siempre una puta mierda como juego, pero no se puede negar que el jodido impresiona todavía. Para mí es el hijo más claro de ese “3d con shaders“.

Braaainz…

¿Y qué vino después? Durante el proceso de la guerra de gráficas en PC, aparecieron las consolas precursoras de las actuales Plays y Xboxes. Con arquitecturas un poco diferentes – o completamente diferentes – a los PC, permiten a los programadores exprimir el hardware al máximo y mostrar cosas que en un PC con los mismos recursos serían impensables. La llamada “next gen” está siempre a la vuelta de la esquina, con la promesa de más y mejor.

Pero el hecho de tener shaders simplemente no significa que un juego sea mejor – todos esos palabrejos que antes hacían que a cualquiera se le cayeran las bragas ahora ya no tienen mucho sentido. Sí, todos esos efectos todavía se usan (y con versiones muchísimo mejores, sólo que ya no te das cuenta que bloom está porque no te quema los ojos como en el gears of war original), pero el santo grial está en otro sitio: la iluminación.

Después de muchos años y mucho experimentar, estaba claro que lo que cambia todo realmente es la iluminación. Y por eso, el enfoque pasó de “más polígonos” a “más luces”.

Pero, ¿qué pasó con Carmack? Pues Doom 3 pasó.

Después de Quake (el 1, y el 2, y el 3…), era hora de volver a Doom. Doom 3 fue el máximo exponente en su época de un “monstruo híbrido”: parte shaders en GLSL, parte shaders en su propio lenguaje (para definir materiales – como en Quake 3), parte fixed function pipeline (las gráficas no eran tan potentes todavía). El resultado final fue bastante bueno (en su momento), pero se perdió algo por el camino.

¡Sed testigos!

Así que en la siguiente interacción de su motor, Carmack pensó que lo mejor sería darle a los artistas control absoluto: gigas y gigas y gigas de memoria para sus texturas. Y así salió Rage, que se ve bonico pero no avanza en la dirección técnica que debería.

Después de problemas legales con id por su participación en el Oculus, Carmack decidió dejar la empresa y dedicarse a la realidad virtual al 100%. Nos quedamos así un poco huérfanos y un poco tristes, sabiendo que el último gran avance de Carmack fue realmente Doom 3 – darle el control total a los artistas nunca fue bueno, y Rage es la prueba.

Espera, espera… ¿y John Romero?

Romero se perdió durante años: tras las peleas interminables con John Carmack y sus múltiples problemas (alcohol, sexo, fiestas y gastos desenfrenados) se separó de id dolorosamente. Durante años trabajó en un juego que nos convertiría en sus bitches, y de ahí salió el lamentable Daikatana, hecho sobre el motor de Quake 2. Fue tan mierder, que el hombre desapareció del mapa durante un buen tiempo. Pero antes de esa transición, nos dejó un legado importantísimo: fue el padre de los FPS multijugador actuales. Realmente no debería aparecer en esta entrada, pero necesitaba una excusa para poner su foto.

Me cepillé a la Killcreek… ¡y lo sabes!

Sin papá Carmack y con las consolas lastrando el potencial verdadero de los gráficos en PC, ¿a dónde vamos ahora?

En el próximo capítulo (el siguiente viernes) el desenlace de la saga técnica más impresionante jamás vista en internet: las sombras suaves de The Last of Us y la mierda ultra borrosa los cuarenta y cuatro millones de filtros de post-procesado de The Order y las predicciones de Yayo para el futuro.